Louis Renard über die Campixx 2022 – der Recap

Bei meiner ersten Campixx fiel mir gleich auf, dass sie hauptsächlich von jungen Leuten besucht wurde. Abgesehen davon war die Location praktisch gelegen, ein super 4-Sterne Hotel mit angeschlossenem Konferenzbereich!

Ebenfalls kann ich sagen, dass die Planung und Umsetzung der Veranstaltung größtenteils gut organisiert und gelungen war.

Inhaltsübersicht

Tag 1:

- Begrüßung und der erste Vortrag: Negative SEO – Urban Legend oder ernsthafte Bedrohung

- Local SEO – beyond best practice

- Aufräumen & Strukturieren für SEOs: Schritt für Schritt zu mehr Erfolg

- Negativ-SEO Marketing erkennen und beseitigen

Tag 2:

- 1000 Onlineshops im Review – das sind SEO-Prinzipien für überdurchschnittliches Wachstum

- SEO Talkrunde mit Gästen

- 7 fatale SEO Schwachstellen großer Onlineshops nutzen, um Profit zu machen

- Inhouse SEO Gehälter 2022 – eine wissenschaftliche Untersuchung

- 9 SEO Fails und Learning der letzten 24 Monate, die jeder Webmaster kennen sollte

TAG 1: BEGRÜßUNG UND DER ERSTE VORTRAG VON RALF SEYBOLD

NEGATIVE SEO: URBAN LEGEND ODER ERNSTHAFTE BEDROHUNG

Nach der Begrüßung von Marco Janck, der noch einmal zur Location und zum Rahmenprogramm etwas sagte, besuchte ich meinen ersten Vortrag auf der Campixx. Dabei stand zunächst die Frage im Raum: Was sind reale Gefahren und was Urban Legends – welche Gefahren gibt es und wie schütze ich mich vor diesen? Ralf erklärte uns, dass wir den Fokus auf Backlinks setzen müssen, schlechte Backlinks erkennen und die daraus folgenden Maßnahmen ableiten sollen. Wie können aber schlechte Backlinks erkannt werden? Google selbst ist an der Thematik Backlinks schon dran, wobei dennoch die allgemeine Effektivität dabei in Frage gestellt wird (teils klappen Gegenmaßnahmen zufriedenstellend, teils bleibt die Erkennung mangelhaft).

Anschließend wurde sich mit der Thematik auseinandergesetzt, wie Google Links/Spaminhalte im Allgemeinen bekämpft. Dabei wurden vor allem die Google Updates besprochen und näher darauf eingegangen, was eigentlich schlechte Backlinks sind. Grundsätzlich sind das solche, die thematisch keine Relevanz aufweisen.

Anschließend kam die Frage auf, wie schlechte Backlinks eigentlich entstehen und dann einzelne Entscheidungsmöglichkeiten vorgestellt:

- Hacking – kapern der Search Console oder der robots.txt

- Hotlinking über Bilder – Gegenmaßnahme wäre die regelmäßige Nutzung des Disavow-Tools

- Bekannte negative Linkformen – Google hat diese im Blick und weiß diese zu bewerten

- Content Diebstahl – manuelle Einreichung bei Google möglich schnelle Redaktionszeit durch die Suchmaschine (Erfahrungswerte)

Nofollow-Backlinks können entgegen der allgemeinen Annahme dennoch schädlich sein, ebenso sind Verlinkung aus „spamigen“ Branchen weiterhin schädlich. Wann ist also ein Linkaudit nötig? Genau dann, sobald unerklärliche Rankingverluste entstehen, ob nun seitenweit oder einzelne Keywords. Die anschließenden Maßnahmen sind dann:

- Disavow

- Content Spam

- Dublicate Content auf Fremdseiten reporten

Fazit des Vortrags: Backlinks sind nicht tot. Schlechte Backlinks sollten durch regelmäßige Backlinkaudits aufgedeckt und bekämpft werden (Disavow-Nutzung). Ebenso sollten wir konsequent Dublicate Content auf Fremdseiten bei Google melden – auch dadurch lernt die Suchmaschine.

ANDREAS PANTELIC:

LOCAL SEO – BEYOND BEST PRACTICE

Im nächsten Vortrag erklärte Andreas, dass er in einem Unternehmen mit einer sehr hohen Standortanzahl von 100+ arbeitet. Er legte seinen Fokus auf My Business Einträge. Dabei riet er uns, die Einträge regelmäßig anzupassen, gegebenenfalls auch durch die Veröffentlichung von Newsbeiträgen „für Google“, auch wenn sie weniger für die Nutzer sinnvoll sind. So kann man der Suchmaschine eine Aktivität aufzeigen, auch wenn es nichts Besonderes zu berichten gibt. Darüber hinaus sollte man Rezensionen innerhalb von My Business ernst nehmen und auch auf diese eingehen.

Der Vortrag befasste sich anschließend noch mit extern entwickelten Tools zur Übersichtserstellung für eine sehr große Anzahl von Standortseiten. Andreas meinte dazu, dass die Datenlage für Standortseiten gepflegt werden sollte – jeder Standort sollte immer aktuelle Daten beinhalten, wobei auch die Abstimmung mit Standortleitungen wichtig ist. Es folgte eine Toolvorstellung bezüglich Zugriffsaufkommen für am Raster ausgerichteter Bereiche, um einzelne Standorte sowie deren Auswertung. Dabei bezog er sich sehr auf ein einzelnes Projekt, wodurch ich den Input für allgemeine Aussagen vermisste.

NIELS DAHNKE:

AUFRÄUMEN & STRUKTURIEREN FÜR SEOS: SCHRITT FÜR SCHRITT ZU MEHR ERFOLG

Im Allgemeinen muss ich zu diesem Vortrag sagen: Er war sehr gut besucht und ebenso gut strukturiert sowie informativ! Folgendes konnte ich dabei mitnehmen:

Gründe für das Aufräumen einer Domain:

- Gewachsene Strukturen

- Veränderte Anforderungen

- Geänderte Domainschwerpunkte

- Veralteter Content

Grundaussage: Viel hilft viel stimmt nicht – Qualität der Inhalte ist relevant.

Domain analysieren mit bekannten Tools (Sistrix, Screaming Frog, etc.):

- Erweitert auch logfile Analyse für wichtigste Seiten die für Suchmaschinen wichtigsten Seiten für interne Verlinkung nutzen

Crawl-Optimierung:

- Ist Crawl in akzeptabler Geschwindigkeit möglich oder Crawlbudget recht schnell aufgebraucht?

„Alten“ Content löschen:

- Aussagen von Google nicht eindeutig

- Inhalte ohne Traffic sind auch ohne Funktion

- Ähnliche Inhalte zusammenführen, ähnliches gilt für Thin-Content

- Veraltete Inhalte, wenn möglich, aktualisieren (teils bedeutet dies auch nur Inhalt verlängern)

- Alte, essentielle Inhalte in eigenes Archiv oder eigene Subdomain auslagern

- Veraltete Inhalte, die dennoch übrigbleiben (keine Aktualisierung), konsequent löschen

- Nutzung von 301 Weiterleitungen für noch rankende Seiten

- Nutzung des Statuscodes 410 für dauerhaft gelöschte Seiten

- Beachtung bei Inhaltslöschung: Wird interne Verlinkung dadurch beeinträchtigt?

Fazit: Inhalte regelmäßig überarbeiten und aussortieren, falls kein Traffic generiert wird. Bei Bearbeitung immer interne Verlinkung beachten. Nutzung von Archiven und Subdomains für dauerhaft relevante Inhalte.

LARS WEBER:

NEGATIV-SEO MARKETING ERKENNEN UND BESEITIGEN

Im Allgemeinen muss ich sagen, dass dies eine sehr hektisch vorgetragene Präsentation war. Zudem war der Vortrag sehr ähnlich zum Vortrag „Negative SEO: Urban Legend oder ernsthafte Bedrohung“ von Ralf Seybold. Dennoch konnte ich einiges mitnehmen:

Es sollte eine dauerhafte Kontrolle der eigenen Keywords, Backlinks und negativen Bewertungen (My Buisness), etc. erfolgen:

- Negative Bewertungen melden (Reaktionszeit der Suchmaschine recht schnell) – keine direkte Stellungnahme schreiben, da dies als „Schuldeingeständnis“ von Google bewertet wird (Bewertung melden, Rechtsanwalt)

- Bewertungsportale/Erfahrungsberichte regelmäßig prüfen – negative Einträge können weiterführende Probleme verursachen

Gesperrte Keywords:

- Beachtung bei Content-Optimierung auf gesperrte Keywords

- Keyword-Prüfung in Ads auf gesperrte Keywords für problematische Themen – gesperrte Keywords können auch verwandte Keywords oder andere Sprachen sein, die ebenso negativ bewertet werden (werden oft übersehen bzw. nicht erkannt)

Backlinks:

- Regelmäßig Detox durchführen

- Keine Forenbacklinks

- Nofollow-Backlinks können in großer Anzahl auch negativ wirken

Mein Fazit: Eine gewisse Paranoia gegenüber dem Wettbewerb ist nicht verkehrt. Angriffe können jederzeit, auf verschiedensten Kanälen stattfinden. Eine ständige Kontrolle und Recherche sind also essentiell.

TAG 2

1000 ONLINESHOPS IM REVIEW – DAS SIND DIE SEO-PRINZIPIEN FÜR ÜBERDURCHSCHNITTLICHES WACHSTUM

Grundsätzlich muss ich zu diesem Vortrag sagen, dass es schwierig war, eine Zusammenfassung zu erstellen, da „nur“ einzelne Beispieldomains kurz analysiert wurden. Ich erfuhr, dass Vorbilder für den eigenen Wachstum nicht Amazon und Co. darstellen sollten, sondern kleinere Marktteilnehmer mit sehr hohen Wachstumsschüben. Anschließend wurde der eigene Index (DESI 250) vorgestellt, welcher nur Online Shops beinhaltet sowie über den gesamten Vortrag hinweg ausschließlich Fallbeispiele genutzt.

- Grund für fallende CRT – meist verlorene Feature Snippets

- -> Fallbeispiele für erfolgreiche Feature Snippets

Übersichten über vollständige und tatsächlich rankende URL-Anzahl für Fallbeispiele:

- Je dichter beide Werte zusammenliegen, desto besser – IKEA als positives Beispiel

- Interne Verlinkungen nur auf rankende URLs setzen

- USPs für alle relevanten Seiten hinterlegen

- -> Positives Beispiel „Breuninger“

- Große Markenverzeichnisseiten sinnvoll

- Produktseiten und Markenseiten effektiv untereinander verlinken (Nutzung von Breadcrumps etc.)

- Hauptkategorien sollten Kategorien des Nutzerintent abdecken (Blogthemen, etc. inhaltlich mit abdecken)

Tipps:

- Thematisch passende interne Verlinkung

- Themenfremde Links vermeiden – kein Megamenü

Zum Schluss wurde erklärt, dass Domains mit positiven Core Web Vitals im Top Bereich des Indexes aufgefunden wurden – bezogen auf alle Domains lässt sich mit DESO 250 jedoch keine Schlussfolgerung daraus ableiten, da sich auf alle Domains bezogen diese Feststellung relativiert. Es konnte somit keine abschließende Aussage über die Relevanz der Core Web Vitals getroffen werden.

MARCO JANCK, OLAF KOPP, STEFAN GODULLA, JOHAN VON HÜLSEN, MAIKE SCHULTZE-RHONHOF:

SEO TALKRUNDE MIT GÄSTEN

Anschließend besuchte ich mit Silvio die SEO Talkrunde. Meiner Ansicht nach wurden teils relativierende Aussagen getroffen, zum Beispiel beim Thema Backlinks: Backlinks sind wichtig, aber auch nicht wichtig, interne Verlinkungskonzepte funktionieren, jedoch für jede Seite individuell.

Mein Fazit: Alle Anpassungen sind für jede Seite individuell, pauschale Aussagen sind so gut wie nie möglich.

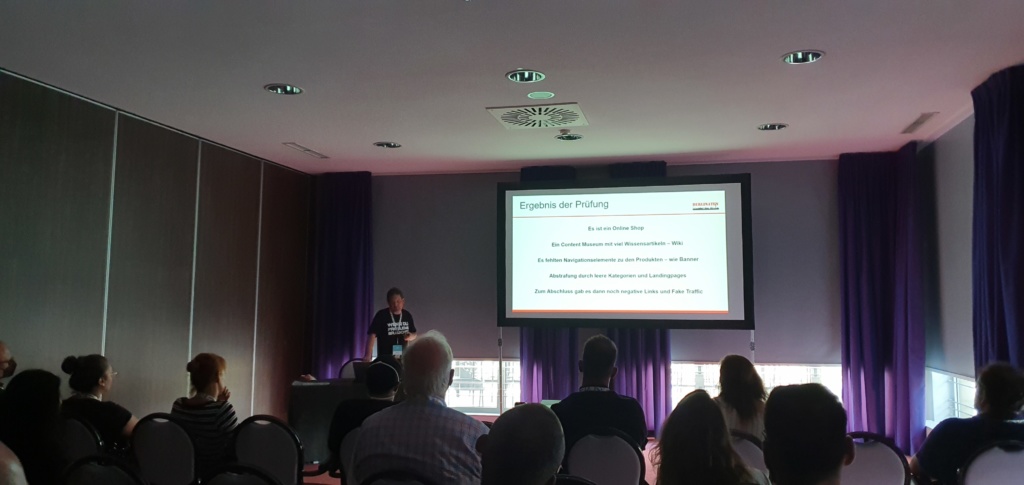

NEDIM SABIC:

7 FATALE SEO SCHWACHSTELLEN GROßER ONLINESHOPS NUTZEN, UM PROFIT ZU MACHEN

Im Folgenden zog es mich zum Vortrag über SEO Schwachstellen. Zu diesem muss ich grundsätzlich sagen, dass es ein strukturierter Vorgang mit teils plakativen Aussagen war. Zu Beginn wurde uns das Ziel genannt, einen Onlineshop in 90 Tagen mit 5000,00 € umzusetzen.

Wie könnte so ein Shop aussehen und was unterscheidet ihn von großen Onlineshops:

1.Wichtig für Anfang – Shopinhalt zu 25 % Spaß an Produkten und 75 % Expertise

- Starke Shopspezialisierung – wenige Produkte

- Produkte aus Deutschland (Importprobleme umgehen)

2. Keywords nutzen, die durch Filter nur schwer dargestellt werden können:

- KWs „mit…“

- KWs „für…“

- KWs „ohne…“

- -> Kombination der Varianten nutzen

3. Onlineshop testen

- Bestseller erkennen und fokussieren; Produkte und KWs testen

- z.B. idealo Testshop

- Testen von Ads, SEO, Upsell

Kleine Produktpalette:

- Rationeller Kauf – SEO/SEA

- Emotionaler Kauf – Social Media

4. Vergleich großer vs. kleiner Onlineshop

- Kleiner Shop – wenige Produkte – Extremfall = 1-Produkt-Shop

- Fokus auf Support (Live Chat, etc.)

5. Kategorietexte

- Texte, die alle Fragen beantworten

- Infografiken nutzen

- Konfigurator – klein halten mit wenigen Einstellungen

6. Linkbuilding

- z.B. über pressemiteilung-ots.de

- Nutzung von Reddit, Frageportale, Gastbeiträge -> klassisches Linkbuilding

- Nutzung von Shopify für kleine Shops sinnvoll

- Beachtung: Marge darf nicht kleiner als 30 % sein

DOMINIK SCHWARZ:

INHOUSE SEO GEHÄLTER 2022 – EINE WISSENSCHAFTLICHE UNTERSUCHUNG

Im Vortrag von Dominik lernte ich, dass weniger Tagesgeschäft und mehr Mitarbeiterverantwortung mehr Geld bedeutet. Zudem zahlen größere Unternehmen im Schnitt besser, wobei die Gehaltsschere zwischen Mann und Frau auch in der SEO deutlich zu sehen sind. Leider waren Agenturen nicht Teil der Analyse.

SEBASTIAN PROHASKA:

9 SEO FAILS UND LEARNING DER LETZTEN 24 MONATE, DIE JEDER WEBMASTER KENNEN SOLLTE

Danach ging ich zu Sebastians Vortrag, der Fallbeispiele vorstellte, welche sich stark auf die eigene Agentur/Domain bezogen. Er behandelte unter anderem das Thema, was Youtube für die SEO bringt. Tatsächlich hat sie keinen übermäßigen Einfluss auf die Sichtbarkeitsentwicklung und Auffindbarkeit, die Nutzung für eine alleinige Ratingverbesserung ist also weniger sinnvoll. Dafür ist die Response durch Youtube aber viel höher als bei einem Blogartikel, durch die direktere/persönlichere Ansprache.

Bei Blogartikeln gilt: Weniger ist mehr. Dazu muss ich aber sagen, dass die besprochenen Blogartikel sehr umfangreich waren, mit teils bis zu 110 Stunden Erstellungszeit! Es ist zudem wichtig, Blogartikel regelmäßig zu updaten und jene ohne Mehrwert zu entfernen. Hier sollte bereits bei in der Planung „Themensiloing“ betrieben werden.

Beim Thema Seitenanpassungen wurde uns geraten, alle Anpassungen (Frontend/Backend) lückenlos aufzuzeichnen. Inhaltlich ähnliche Themen sollten zudem nicht gleichzeitig bearbeitet werden (Kategorieseite, Blogseite, etc.), da die Suchmaschine so die „Fokusseite“ verliert. Das Ergebnis: Beide Seiten verlieren an Sichtbarkeit.

Es folgte eine größere Diskussion zu Veröffentlichkeitsdaten bei Blogartikeln. Es kristallisierte sich heraus, dass die Nutzung sinnvoll ist, jedoch sollten dann die Artikel regelmäßig angepasst werden, damit das Datum aktuell bleibt. Ebenfalls ist das Ausschalten der Daten in Snippets teils kompliziert – ob das also zielführend ist, bleibt offen. Darüber hinaus sollte die manuelle Anpassung des Veröffentlichkeitsdatums ohne Anpassung des Artikels vermieden werden. Inwieweit das die Suchmaschine aber bemerkt, blieb ebenfalls offen.

Wobei dürfen unsere Experten Sie unterstützen?

- DER CAMPIXX RECAP VON UNSEREM ONLINE MARKETING KOLLEGEN LOUIS

- LOCAL SEO – BEYOND BEST PRACTICE

- AUFRÄUMEN & STRUKTURIEREN FÜR SEOS: SCHRITT FÜR SCHRITT ZU MEHR ERFOLG

- NEGATIV-SEO MARKETING ERKENNEN UND BESEITIGEN

- 1000 ONLINESHOPS IM REVIEW – DAS SIND DIE SEO-PRINZIPIEN FÜR ÜBERDURCHSCHNITTLICHES WACHSTUM

- SEO TALKRUNDE MIT GÄSTEN

- 7 FATALE SEO SCHWACHSTELLEN GROßER ONLINESHOPS NUTZEN, UM PROFIT ZU MACHEN

- INHOUSE SEO GEHÄLTER 2022 – EINE WISSENSCHAFTLICHE UNTERSUCHUNG

- 9 SEO FAILS UND LEARNING DER LETZTEN 24 MONATE, DIE JEDER WEBMASTER KENNEN SOLLTE